-

Compteur de contenus

5 387 -

Inscription

-

Dernière visite

-

Jours gagnés

9 -

Last Connexion

Soon available - 42676

George Black a gagné pour la dernière fois le 7 avril

George Black a eu le contenu le plus aimé !

Réputation sur la communauté

5 798 Très bonne réputationÀ propos de George Black

-

Rang

Membre hyperactif

Informations personnelles

-

Instruments

114/900

Visiteurs récents du profil

-

Je n'irai pas jusque là. Certes, si c'est confirmé, c'est un résultat d'importance majeure pour notre compréhension de ce qu'est l'énergie sombre. Et notamment pour espérer mieux connaître l'avenir de notre univers (entre Big Rip, Big Crunch, etc...). Mais je n'aime pas la notion de "qui défie notre compréhension". Cela a l'air de dire que les scientifiques sont convaincus que l'énergie sombre doit être constante dans le temps, et que si ce n'est pas le cas, on ne comprend plus rien ! Or ce n'est pas ce qui se passe. Il y a pléthore d'articles qui entendent se passer de la constante cosmologique (ce qui sera le cas si la découverte est confirmée) et qui cherchent à interpréter l'énergie sombre par l'existence de nouveaux champs. Si l'énergie sombre est constante, et qu'elle correspond bel et bien à un scénario de constante cosmologique, cela pose de profondes questions sur la nature de l'espace-temps. Dans le cas contraire, cela ouvre la porte à de nombreux scénarios, et en fonction des mesures à venir, cela pourrait permettre de faire le tri dans les nombreux modèles publiés.

-

Durée de vie minimale de l'électron

George Black a répondu à un sujet de Huitzilopochtli dans Astronomie générale

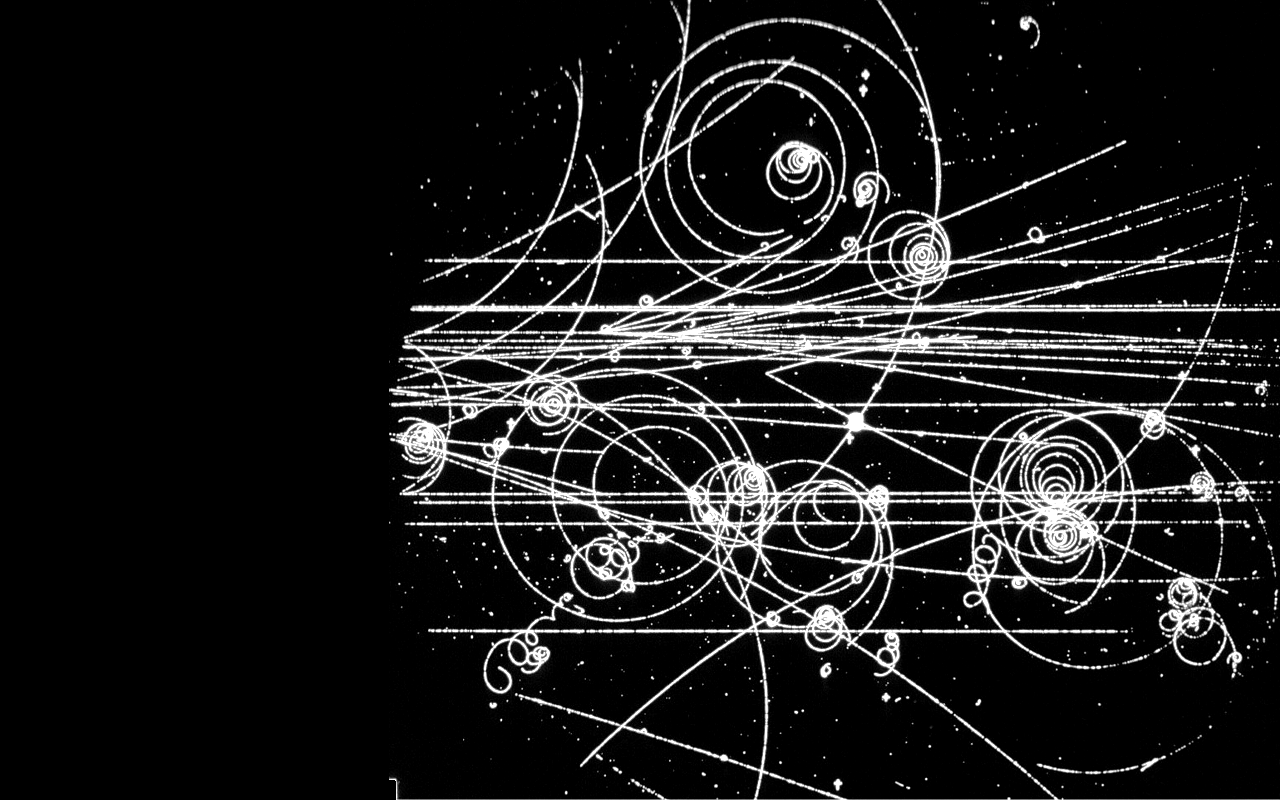

Deux mots (enfin... un peu plus ) 1. Concernant la durée de vie du proton et sa mesure. Je vais illustrer par un exemple. Certaines théories prédisent que le proton peut se désintégrer en une particule que l'on nomme un pion (qui est connue) et un antiélectron. (Note : une certaine manière de se désintégrer se nomme un canal de désintégration) Cette désintégration pion + antiélectron, si elle existe, est possible par exemple dans le noyau du fer. Si je dispose d'une masse de 3,5 tonnes de fer (en gros un cube de 76 cm de côté), cela représente quelques 10^30 protons. Si je suis pendant 1 an ce cube et que je n'observe pas la désintégration attendue (i.e. je ne détecte pas de pion et d'antiélectron émis conjointement), je peux affirmer que la durée de vie du proton (dans ce canal de désintégration) est supérieure à 10^30 ans. Si la durée de vie du proton était de l'ordre de 10^29 ans par exemple, cela signifierait qu'il faudrait attendre cette durée pour espérer observer la désintégration de ce proton. Mais ici, on parle d'un phénomène qui est statistique. C'est une durée de vie moyenne, et donc, si je considère une population de protons, certains se désintégreront plus tôt, d'autres plus tard. Donc, si j'ai 10^30 protons, on peut espérer qu'en 1 an, une dizaine se seront désintégrés. Donc, si je n'observe rien pendant 1 an, cela signifie que la durée de vie dans le canal étudié est supérieure à 10^30 ans. Ce qu'il faut comprendre, c'est que les durées de vie sont en fait reliées à des probabilités de désintégration par unité de temps que l'on nomme "taux de désintégration". Il faut éviter de raisonner en terme de (par exemple) "le proton a une durée de vie 10^21 fois supérieure à l'âge de l'Univers". Il faut raisonner en terme de taux de désintégration, par exemple : 2*10^(-39) /s (en considérant ici le "10^21 fois l'âge de l'Univers"). Cela se lit en disant que la probabilité que le proton se désintègre en 1 s est de 2*10^(-39). Je rappelle qu'une probabilité égale à 1 correspond à un événement certain, et une probabilité de 0 correspond à un événement qui ne se produira pas. On peut aussi dire qu'il y a 2*10^(-39) désintégration par seconde pour un proton. On a donc ici un événement excessivement peu probable, mais observable néanmoins. Si on observe 10^31 protons (35 tonnes de fer) pendant 5 ans (1,6*10^8 s) on peut donc espérer observer (10^31)*(1,6*10^8)*(2*10^(-39)) ~ 3 désintégrations. Ces expériences sont rendues compliquées par le fait que de nombreux phénomènes peuvent conduire à des faux positifs. Il s'agit donc d'expériences remarquablement soignées pour éviter la radioactivité des éléments chimiques utilisés dans l'expérience, pour se protéger du rayonnement cosmique, et pour éliminer par traitement du signal les événements indésirables. 2. Concernant la durée de vie de l'électron étudiée dans l'article. Le mécanisme sondé ici est la désintégration d'un électron dans un atome de germanium, plus particulièrement les électrons les plus près du noyau. Les canaux sont assez généraux, il s'agit de canaux conduisant à des états peu ou pas détectables (par exemple des neutrinos). Donc la détection de la disparition de l'électron se fait indirectement. La disparition de l'électron va se traduire par un réarrangement des couches électroniques qui va entraîner un signal électromagnétique spécifique. Comme pour la durée de vie du proton, les auteurs suivent, ici, un bloc de germanium. Comme ils n'observent rien sur le temps d'étude, ils en déduisent leur contrainte sur la durée de vie de l'électron. Ces expériences sont cruciales, car elles fournissent des tests pour de nombreux modèles au-delà du modèle standard de la physique des particules et qui justement savent calculer les taux de désintégration évoqués.- 11 réponses

-

- 11

-

-

-

-

Projets de centrales solaires spatiales : quelles incidences sur l’astronomie ?

George Black a répondu à un sujet dans Astronomie générale

Les défaillances système arrivent aussi sur les machines. Et sur des systèmes complexes (car on ne parle pas de grilles pain), ces défaillances arrivent bien plus souvent que chez l'humain. Ensuite, il ne faut pas oublier qu'en dépit de cela, en usine, on recale l'essentiel des machines défaillantes avant la vente... chez l'humain, on n'est pas trop fan d'eugénisme ! La machine donne une impression de robustesse et d'efficacité qui ne prend pas en compte la complexité et la polyvalence de nos machines biologiques. Actuellement, aucune IA ne cumule les fonctionnalités mentales de l'humain, pas plus qu'aucun robot n'atteint les performances athlétiques de l'humain. Aucun robot humanoïde n'est capable de renvoyer l'ensemble du ressenti corporel d'un humain à son "cerveau". On oublie que nos machines, derrière des prouesses ponctuelles, sont primitives par rapport aux fonctionnalités biologiques. Ma femme, qui est biologiste, me le dit souvent : quand on voit la complexité du vivant (nécessaire à sa richesse en terme de fonctionnalités) il est remarquable que cela ne déconne pas plus ! Attention, je ne critique pas l'aspect "prothèse" dans la relation humain-machine, je dis : attention aux biais cognitifs dans l'idée d'une supériorité de la machine sur l'humain. Je vais reprendre une expression de mon père : "Il faut arrêter de croire que l'on a spontanément engendré une génération de débiles". Autrement dit, ces jeunes sont comme on les a élevés, ou pas élevés. Il y a un tabou dans nos sociétés occidentales. A une époque où l'on aime pathologiser l'agressivité, les pulsions, et j'en passe, nous renions que nous sommes des primates intrinsèquement violents, agressifs, et dominateurs. C'est une des caractéristiques des espèces sociales et territoriales : la violence et la tendance à l'expansion. Violence et tendance à l'expansion qui émergent jusque dans les comportements sexuels. En tant qu'espèce aspirant à être "humaine" et civilisée, plus réfléchie, nous savons que ces comportements ne sont pas optimisés par rapport aux bénéfices de l'altruisme. Et ces comportements, à juste titre, sont considérés comme indésirables dans une civilisation digne de ce nom. Cette part de notre animalité n'est pas acceptable. Là où je parle de tabou, c'est que, encore une fois, nous avons tendance à pathologiser ces comportements et à renier qu'ils font partie de nous. La violence (au sens général) devient une déviance, une pathologie, pas une tendance naturelle. Dès lors, comme pour de nombreuses pathologies vues comme honteuses ou qui font peur, on aime à penser qu'elle ne concerne que l'autre, pas nous, pas notre entourage, et qu'elle relève d'une forme de fatalité. Il y a une forme de déni. Pourquoi est-ce dangereux ? Parce que cela nous absout d'une tâche fastidieuse et complexe : l'éducation ! Car l'éducation, le transfert de l'expérience collective humaine à un autre humain, c'est ce qui nous éloigne de l'animalité ! Un enfant ne nait pas humain, il nait homo sapiens, et il deviendra humain par l'éducation, par la transmission de l'essence de l'expérience humaine globale cumulée sur des milliers d'années. L'homo sapiens seul, relativement isolé, est un animal, l'homo sapiens sociabilisé, instillé par la culture humaine globale, devient humain. Pour reprendre la formule de je ne sais plus quel anthropologue, l'humain s'est auto domestiqué ! Homo sapiens est un animal domestiqué par l'espèce humaine ! La pathologisation est dangereuse, parce qu'elle nous absout aussi de notre propre éducation et remise en question. Quand on écoute aujourd'hui les discours de certains courants, dont les masculinistes, quand on analyse les discours d'un Trump, d'un Poutine, etc... on observe une collusion de la partie animale de l'humanité qui résiste à la civilisation. Il y a une revendication au droit à la violence, une légitimation de la domination et de la violence. Notre occidentalisation étant vue d'ailleurs par certains (comme Poutine) comme une décadence, ce qui est assez ironique, car en réalité, ces gens revendiquent finalement un retour à l'animalité. Bref,... il faut arrêter de pathologiser ! On lutte contre toutes les formes de violence en réalisant que tout humain est potentiellement violent ou soumis par essence biologique, et en lui faisant prendre conscience de cela, et en l'éduquant pour lui apprendre à gérer cela pour sortir de ce schéma. J'accuse aujourd'hui les institutions et les parents de ne pas se donner les moyens d'éduquer, et de pathologiser pour se dédouaner de leurs responsabilités ! Dernière remarque : de manière ultime, certains individus resteront hermétiques à la civilisation, préférant le côté animal de manière assumée et totalement débridée. Les civilisés qui auront totalement oublié la violence se heurtent alors au risque d'être victimes des ultimes barbares. Il est alors nécessaire pour une civilisation d'être dotée d'une violence légitime pour assurer sa propre défense. Mais la violence légitime ne peut se substituer à l'éducation. Dernière dernière remarque : Il est remarquable que les tenants de la lutte contre les violences (diverses et variées), qui sont dans la pathologisation, la dénonciation de la déviance, soient systématiquement dans le discours répressif, donc violent, et n'abordent jamais le volet de l'éducation. C'est éloquent dans le débat sur la fessée, où indépendamment de la réalité des violences éducatives et de la maltraitance, on propose de remédier à la fessée en appelant à des textes répressifs. A aucun moment ces gens ne parlent d'éducation à la parentalité. Ainsi, il est fréquent de voir actuellement des gens prétendre lutter contre les violences et les discriminations en faisant acte de violence et de discrimination, avant même d'envisager une démarche éducative (dont j'ai expliqué qu'elle ne pouvait être remplacée par la violence légitime en première intention), seule durable et efficace. Désolé pour ce hors sujet. -

Modèles alternatifs de cosmologie en 2024: Qui sont-ils et quid de leur pertinence ?

George Black a répondu à un sujet de Pascal C03 dans Astronomie générale

J'ai pris le temps de lire l'article. Je suis un lecteur fréquent des travaux de Gingras dont j'ai pas mal d'ouvrages. Et ce n'est pas du tout ce qui est défendu ici. C'est une analyse du parcours d'un chercheur, ici Nottale, qui part dans un domaine qui n'est pas mainstream. Un collègue de labo de ma femme, disons M. X, avait la fâcheuse réputation de faire souvent maladroitement de la casse. Un jour, en réunion, un autre collègue, M. Y, fit le reproche qu'il ne comprenait pas trop le sens des recherches de X et qu'en plus ce dernier faisait souvent de la casse. La réponse de la directrice du laboratoire à M. Y fut cinglante : "C'est sûr que toi, tu ne risques pas de casser grand chose !". Il était de notoriété que M. Y, par ailleurs agrégé, ne publiait pratiquement jamais, et que quand il avait son nom sur un article, c'était par complaisance, et qu'en bon agrégé, il était fort pour dire aux autres ce qui était bien ou mal en terme de science. Par ailleurs, il faut aussi comprendre un aspect de la recherche. Aujourd'hui, on demande de publier beaucoup, dans des revues prestigieuses, et d'être beaucoup cité, pour espérer obtenir postes et financements. On se retrouve alors sur des échelles de temps et de travail qui n'autorisent pas une excessive originalité. De plus, les organismes de financement tendent à cibler des thèmes prioritaires et dont la masse de chercheurs (pour un thème) offre des garanties de succès. On assiste donc à des transitions vers des thématiques qui deviennent à la mode. On a des groupes sociaux de chercheurs spécialisés sur ces thématiques. Quand on soumet dans ces thèmes, on se retrouve dans une dynamique qui garantit d'être dans une communauté dont les moyens permettent d'espérer d'avoir un poste, des financements... Dès lors, lorsque l'on soumet un article dont l'approche sort de ces groupes, il devient compliqué de trouver des reviewers capables de relire le travail. Le même phénomène tend à se produire quand le travail est à cheval sur plusieurs groupes. Il n'y a pas besoin d'arriver avec une théorie en rupture totale avec ce qui se fait ! Il suffit juste ne pas être à la mode du moment ! Dès lors, les reviewers seront tentés de rejeter l'article, non pas par conformisme, mais par crainte d'accepter un papier bullshit faute d'avoir l'expertise nécessaire. De plus, même si on parvient à publier, comme on ne sera pas dans un thème à la mode, on sera peu cité, vu que la majorité des autres collègues seront sur des thèmes à la mode ! Les expérimentateurs peuvent difficilement se permettre d'être trop en dehors des clous : pas de sous, pas de manip ! Mais ils ont des bonnes stratégies pour s'en sortir. Dès lors, il n'y a guère que quand est théoricien et que l'on a la sécurité du poste, et que l'on ne cherche pas à être une vedette d'un star-système, que l'on peut prendre le risque à sortir des clous. Mais ce qu'il faut retenir, c'est que toute idée correctement construite finit toujours par trouver son chemin ! -

Modèles alternatifs de cosmologie en 2024: Qui sont-ils et quid de leur pertinence ?

George Black a répondu à un sujet de Pascal C03 dans Astronomie générale

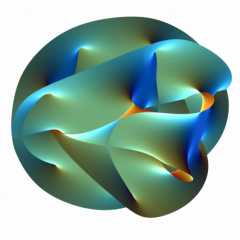

Je me demande en fait ce qui est attendu ici ?! Qu'est-ce qu'un modèle alternatif ? 1. Qu'est-ce que la cosmologie ? La première chose que l'on constate souvent dans le grand public, c'est l'incompréhension autour du modèle de concordance, perçu comme sorte de théorie monolithique. Comme si la cosmologie reposait sur la seule relativité générale. En réalité, la cosmologie nécessite de comprendre de nombreux phénomènes physiques qui interagissent ensemble. Aussi, la cosmologie repose sur l'étude de : - La relativité générale pour comprendre la dynamique globale de l'Univers en terme d'expansion - La gravitation (je nuance par rapport à la RG) pour étudier la formation des galaxies et des structures galactiques - La physique nucléaire pour comprendre la nucléosynthèse - Les deux domaines précédents pour comprendre la formation des étoiles - La physique des particules pour comprendre, entre autres, la baryogénèse - La physique des plasmas nécessaire sur plusieurs niveaux précédents - etc, etc... La cosmologie peut se ranger dans ce que l'on nomme aujourd'hui la multiphysique, i.e. l'étude des phénomènes complexes qui demandent des calculs faisant intervenir différents champs de la physique. N'en déplaise à certains, il n'y a pas d'ayatollahs du modèle de concordance. Les gens qui affirment cela sont des ignorants dont la suffisance les conduits à affirmer des contre-vérités qui appuient leurs délires complotistes, et dont la paresse intellectuelle ne les encourage pas à s'informer ce qui leur permet de se complaire dans leurs certitudes (l'éternel fantasme de la lutte du bon peuple contre les notables pervertis). Au passage, il est amusant de voir des gens défendre JPP en surfant sur son délire de "il n'y a pas de matière noire" alors que Janus EST un modèle de matière noire (indépendamment de sa cohérence physique et mathématique). Je ne connais aucun cosmologiste qui affirme que tout est compris. En l'occurrence, si c'était le cas, on arrêterait les missions d'études et on ne verrait pas fleurir des articles théoriques à la pelle ! Donc, ce qu'il faut comprendre, c'est que quand on s'interroge par exemple sur la formation des galaxies, cela ne signifie pas pour autant que l'ensemble de la physique connue est à revoir ! On ne commence pas par dire qu'il faut fiche à la poubelle la physique nucléaire et la physique des plasmas ! 2. Comment fonctionne la recherche ? De même, en physique, quand on a une théorie qui a marché parfaitement dans 999 expériences différentes, on ne la fiche pas à l'air à la première expérience qui semble en désaccord. On va déjà essayer de voir si cette dernière expérience ne comporte pas d'erreurs, et ensuite la répéter de diverses manières pour confirmer le résultat. Ensuite seulement il faudra retravailler la théorie. Mais là encore, cela ne signifie pas forcément de tout devoir repenser. Certains parlent de la matière noire comme d'une théorie des épicycles. C'est là encore mal comprendre le fonctionnement de la science. Ainsi, on aurait pu taxer le modèle de Bohr de l'atome comme une sorte de théorie des épicycles, une tentative de concilier maladroitement la mécanique classique avec les observations. Cela serait faire un procès injuste au travail de Bohr qui a justement permis à de Broglie de poser les bases de ce que l'on allait nommer la mécanique ondulatoire qui deviendra la physique quantique. Si on n'enseigne plus la théorie des épicycles (sinon en histoire des sciences), le modèle de Bohr est encore enseigné comme accroche à la physique quantique. Autre exemple : depuis que l'on connait la relativité restreinte, les ingénieurs en automobile continuent à utiliser la mécanique classique ! La physique classique est inclue dans la physique relativiste. Pour dépasser quelque chose, on a besoin de s'appuyer sur l'existant au risque sinon de s'égarer totalement (et surement). Pour reprendre Oscar Wilde : "Appuyez-vous sur les principes, ils finiront bien par céder". De même, certains ont une vision totalement erronée du fonctionnement de la science en terme de temporalité. Ceci dit, les scientifiques en sont aussi parfois victimes, un peu comme si une recherche qui s'inscrivait dans un temps trop long était synonyme d'absence de découverte possible. C'est la différence entre Katalin Karikó (prix Nobel pour le vaccin à ARN) ou Isamu Akasaki (prix Nobel pour la LED bleue) et les autres : l'opiniâtreté là ou les autres ont jeté l'éponge, abandonnés par l'espoir de découverte ou de profit rapide en terme de publications. A ce compte-là, on pourrait aussi abandonner toutes les recherches contre le cancer au motif que ça fait plus d'un siècle qu'on cherche à le traiter ! 3. Mais alors c'est quoi un modèle alternatif de la cosmologie ? Au sens strict, il n'y en a pas vraiment ! En revanche, le modèle de concordance n'est pas défini à certaines échelles de temps qui correspondent justement à des trous dans le tissu de nos connaissances en physique. Un exemple : la baryogénèse. En fait, il ne devrait pas y avoir de matière dans l'univers (ou presque) ! Dans les premiers instants, il y avait un équilibre thermodynamique entre le bain de photons et les particules élémentaires. Pour ces dernières, on doit avoir autant de particules que d'antiparticules. Avec l'expansion et le refroidissement de l'Univers, les particules et les antiparticules auraient dû pratiquement totalement s'annihiler pour ne laisser qu'un résidu de particules et d'antiparticules dans des quantités considérablement inférieures à ce que l'on observe aujourd'hui. En l'occurrence, on n'observe pas de structures constituées d'antimatière, et notre univers est largement dominé par la matière, même s'il y en a très peu : en gros 1 proton pour 4 mètres cubes. C'est ce que l'on nomme le problème de la baryogénèse. Sakharov a montré que cela n'était possible qu'à 3 conditions (qui portent désormais son nom) présentes au moment de la baryogénèse : - Les particules et les antiparticules doivent avoir un comportement différent (en terme techniques, on parle de violation C/CP). - Il doit exister un processus qui viole la conservation du nombre baryonique, celui-ci étant nul avant la baryogénèse, et non nul après. - Il doit y avoir une rupture de l'équilibre thermodynamique. Aujourd'hui, on ne sait pas ce qui est à l'origine de la baryogénèse. En revanche, on ne manque pas de modèles ou théories candidates pour l'expliquer. En ce sens il y a de nombreux modèles alternatifs. A ce stade, ce qui manque, c'est des expériences pour invalider des modèles ou confirmer quelle est la bonne interprétation. 4. Pourrait-on parler de ça ici ? Objectivement, cela n'est pas forcément évident. Concernant la violation C/CP, certains mécanismes permettant de la décrire sont terriblement abstraits et techniques. On ne peut qu'en dresser l'idée générale et à ce stade, le lecteur curieux et non spécialiste doit accepter de faire confiance aux chercheurs, car aucun quidam n'est jamais assez fort pour ce calcul.- 42 réponses

-

- 14

-

-

-

-

-

Projets de centrales solaires spatiales : quelles incidences sur l’astronomie ?

George Black a répondu à un sujet dans Astronomie générale

J'ai d'ailleurs toujours été fasciné par les transhumanistes et cette lubie de la mécanisation. On ira trouver une machine capable de tenir 80 ans voir plus sans changement de pièces. J'ai une voiture qui a 17 ans, elle a connu des changements de phares, de courroies, de batterie, de pompes, de câblages, des rayures, des zones enfoncées, des problèmes de vitres, et j'en passe, etc... j'imagine si un humain devait déjà subir entre sa naissance et sa majorité un changement total de ses dents déjà en rade, une transplantation cardiaque, une greffe de tendons, etc etc... La machine vivante s'autorépare, a une longue durée de vie, plus que n'importe quelle machine. Le vivant est tellement performant que de nombreux ingénieurs essayent de s'en inspirer, jusqu'à essayer de créer des technologies d'autoréparation ! La machine n'offre que l'illusion de la longévité ! -

Projets de centrales solaires spatiales : quelles incidences sur l’astronomie ?

George Black a répondu à un sujet dans Astronomie générale

Cela dépend du public... J'interviens en terminale et BTS en lycée et master à la fac. Pour les premiers, aucun besoin de réguler. Pour les derniers non plus. En revanche, pour les BTS, l'utilisation compulsive et sauvage du smartphone est un réel problème, et donc on a fabriqué des "hôtels à portables" à la découpeuse laser pour qu'ils les déposent en début de cours. Un point dramatique : Je précise que nos terminales sont pratiquement toutes et tous des enfants d'universitaires, médecins, avocats, etc... que pratiquement la moitié part en CPGE (dont Saint Louis, Kleber, Poincaré,...) et qu'une autre moitié part en médecine. Les rares qui partent en fac, c'est parce qu'il n'y a pas de CPGE associée à leurs parcours de formation. Pour nos étudiant(e)s de master, on a modifié les critères de recrutement il y a quelques années. On était descendu à un niveau très bas, ce qui posait des problèmes de recrutement en thèse. Aujourd'hui, beaucoup de nos masters sont des gens avec un parcours CPGE + licence ou encore CPGE + ingénieur avec retour sur la physique fondamentale. En revanche, nos BTS sont à plus de 50% des gens issus de bac pro. Cette année, on en a qui se sont fait virer tellement l'absentéisme est massif quand d'autres (en alternance) se sont fait simplement virer de leur entreprise. Pour faire simple, je dirais : "Dis moi ton origine socio-culturelle, et je te dirai quelles études tu fais ou feras, et quel est ton rapport au smartphone". Malheureusement, on le constate, et c'est corroboré par des vraies études, tu peux remplacer "smartphone" avec "tabac" ou "alcool". On a dû faire venir des intervenants pour sensibiliser les étudiants à ces problèmes ! On a tout de même eu des étudiants souls en cours quand un autre a été hospitalisé pour emphysème pulmonaire en raison de sa consommation de tabac. -

Projets de centrales solaires spatiales : quelles incidences sur l’astronomie ?

George Black a répondu à un sujet dans Astronomie générale

Certes... mais avec "4 000 miroirs ronds, de 1 kilomètre de diamètre chacun, placés sur une orbite terrestre basse, à 890 kilomètres de la Terre", je me demande le coût de l'électricité ?! Il va falloir rentabiliser et entretenir ce parc de satellites. Mais aussi, quid de la production d'énergie en terme de "volume" ? Les chiffres donnés laissent à montrer que l'on part sur un projet pharaonique pour un résultat décevant. Sans compter la fragilité de structure. Que les satellites passent au dessus de la Russie, quelques missiles bien placés, et hop, l'Europe dans le noir ! Pour moi, on est dans le même délire qu'avec Desertec... Je ne parle pas d'impossibilité technologique, mais de projet qui ne tient absolument pas compte d'aspects multifactoriels, d'ordre environnementaux et géopolitiques, domaines dans lesquels, par expérience, de nombreux scientifiques et ingénieurs sont particulièrement mauvais faute de s'y intéresser et à se considérer au-dessus de cela. -

Projets de centrales solaires spatiales : quelles incidences sur l’astronomie ?

George Black a répondu à un sujet dans Astronomie générale

Un peu comme ceux qui sont collés à leur smartphone donc ? Il y a pas mal d'études d'opinions qui montre que la génération montante (entre 15 et 30 ans actuellement) aspire à la déconnection. Notamment, on voit un intérêt croissant pour les "dumb phones", le retour du bon vieux Nokia 350i en quelque sorte. Tout comme de nombreuses études sociologiques montrent les dégâts de la connectivité à outrance faisant un lien démontré avec la hausse des dépressions chez les jeunes, les phénomènes de harcèlement, etc... Et il y a des explications claires à cela, comme l'importance du ressenti des micro-expressions dans les vrais échanges dialogués, et l'importance d'une discussion construite et argumentée. Je veux bien être traité de vieux con réac à dire cela. Mais j'assume, car là, on est sur du démontré, et cela revient à se faire traiter de vieux con réac par un jeune à qui on dit que fumer est mauvais pour sa santé et qui vous répond qu'il est jeune et en bonne santé et qu'il arrête quand il veut. A noter qu'un smartphone, on peut s'en détacher ! Le mien est systématiquement en mode sans sonnerie ni vibreur. Je jette un coup d'œil furtif de temps à autre pour vérifier que l'on n'a pas essayé de me joindre. A la maison, il termine posé sur une étagère en dehors du temps de travail. Le jour où l'on passe à la greffe, on est sur un autre registre : la mutilation permanente ! Je suis d'une génération où le tatouage a été à la mode ! Aujourd'hui, les dermatologues expliquent qu'ils n'arrivent plus à suivre les demandes pour essayer de faire retirer des tatouages ! Musk est dans le délire de l'homme augmenté ! Le projet Neuralink vise bien à pousser la population à se faire percer la boite crânienne pour se faire implanter et être connecté h24 au réseau. Certains me diront que l'on aura toujours choix. Je répondrais : "Comme avec le smartphone ?". Parce qu'en ce qui me concerne, je n'ai jamais voulu de smartphone ! J'y ai été contraint, parce qu'à force de geek patrons de sociétés et de lobbying divers et variés, on vous fait comprendre que sans smartphone tu ne pourras pas travailler à tel endroit, parce qu'il faut telle ou telle application, parce que pour accéder à ta banque il te faudra telle autre, etc... Le danger de Neuralink, c'est à dire l'exploitation de connexions neuronales hors contrôle de la législation médicale, c'est d'ici 30 ans de voir un truc à la con du genre : "obligation de connecter chaque citoyen dès l'âge de 15 ans au réseau collectif". Et quelque uns se diront : "comment on a fait pour en arriver là ? comment on a fait pour accepter de voir nos jeunes se faire mutiler à la chaine ?". -

Projets de centrales solaires spatiales : quelles incidences sur l’astronomie ?

George Black a répondu à un sujet dans Astronomie générale

Tout ça pour un système qui représente qu'une petite portion des besoins énergétiques européens... et à peine de quoi sustenter la France... sur fond de crise internationale, un petit missile par ici ou par là depuis le sol d'un pays ennemi, mais avec interception au-dessus de son sol, et hop ! exit la belle centrale solaire ! -

Projets de centrales solaires spatiales : quelles incidences sur l’astronomie ?

George Black a répondu à un sujet dans Astronomie générale

Et après on critique le nucléaire.......... -

la fin de la matière noire .....

George Black a répondu à un sujet de bon ciel dans Astronomie générale

Tout est dit... mais un ressenti, un qualia, n'est pas réel. Pas réel au sens de Philip K. Dick, au sens de "est réel ce qui continue d'exister indépendamment de nous". Le problème c'est que les gens s'attachent trop aux qualia en tant que réalité intrinsèque. C'est le rôle de la méthode scientifique que de repérer le réel comme variable indépendante de nous. J'ai connu des gens (ou des témoignages de gens) qui ont un jour connu une expérience de mort imminente. Certains n'avaient jamais vraiment réfléchi sur eux, la vie, etc... Cette expérience a donc été brutale, le ressenti d'une révélation, et certains sont tombés dans une forme de mysticisme voir dans la religiosité. C'est un peu comme la différence qu'il y a entre les personnes qui prennent des drogues récréatives et qui sont conscientes que ce qu'elles vivent n'est pas réel, et celles qui en prennent et croient en la réalité de leurs expériences, comme ces gens persuadés que le LSD ou autres drogues shamaniques permettent de rentrer en contact avec l'au-delà. -

la fin de la matière noire .....

George Black a répondu à un sujet de bon ciel dans Astronomie générale

Contrairement à ce que vous pensez, je pense au contraire que la conscience à ses limites que la science n'a pas ! Je vous vois surtout partisan du dieu des brèches contre lequel Hubert Reeves mettait en garde ! Je ne comprends pas, donc c'est divin ! Avec le petit supplément sous-entendu en plus de "barre toi de là la science ! c'est mon domaine ! Touche pas à mon irrationnel !" (on ne sait jamais, qu'il y ait une explication rationnelle...) Il y a aujourd'hui des études fascinantes sur ce qui se passe dans le cerveau au moment de la mort et sur les "expériences proches de la mort". Mais visiblement, ces études n'atteignent pas les sphères des adeptes du paranormal ! On entend ici parler dans cette vidéo de mort clinique, d'absence d'activité cérébrale, donc de gens revenus de la mort... Ce qui n'est pas évoqué dans cette vidéo, c'est les limites des moyens employés. Récemment, des méthodes d'analyses plus poussées de l'activité cérébrale, appliquées au moment "de la mort", ont permis de réaliser que même après un arrêt cardiaque et une perte de conscience, l'activité cérébrale perdure de longues minutes et même fonctionne de manière très active par vagues successives, après la disparition "officielle" de l'activité cérébrale. Les aires activées laissent suggérer que la personne est dans un état de rêve très dynamique, pour ne pas dire dans un état hallucinatoire. Là encore, les aires activées semblent indiquer que la personne pourrait se sentir dans un état de béatitude. L'interprétation qui en est faite est que le cerveau cherche à se protéger (suppression des messages de douleur, sauvegarde des capacités cognitives). Dans une de ces études, il était évoqué que ces vagues pouvaient être réversibles, et qu'avant extinction totale du cerveau, il devait être possible de réanimer une personne tant que cette activité était présente. A une époque, quand une personne ne respirait plus et était en arrêt cardiaque, on la disait morte. Ensuite on est passé sur l'électro-encéphalogramme plat. Le fait est que l'on a décrété peut-être un peu vite où fixer la limite de la mort. Il va falloir peut-être passer sur des outils diagnostiques plus puissants. -

la fin de la matière noire .....

George Black a répondu à un sujet de bon ciel dans Astronomie générale

1. Les "preuves" : la pléthore de publications scientifiques sur les différents sujets évoqués. Je ne vais pas faire la biblio ici sur les différents thèmes. On ne parle pas de trois ou quatre articles ! Et je ne suis pas certain que leurs contenus parleraient à grand monde ! C'est par ailleurs le problème intrinsèque à la science actuelle. La compréhension de l'extrême complexité des problèmes abordés demande un fameux bagage scientifique. D'ailleurs, je n'ai pas la prétention de tout maîtriser, mais je fais confiance à la maîtrise des collègues sur leurs sujets. L'erreur intellectuelle du grand public (et pas que) est de croire que toute bonne réponse aux grandes questions est forcément compréhensible par tout à chacun. En tant que physicien, ma curiosité me pousse à m'intéresser aux autres champs disciplinaires des sciences, mais je sais aussi reconnaître quand les choses me dépassent, souvent faute de temps à y investir intellectuellement. J'ai appris depuis longtemps à ne pas coller une étiquette d'intervention divine sur les choses qui me dépassent ! 2. Je n'ai pas dis qu'il était résolu. J'ai dit que l'on savait faire sans intervention divine. Tu es parfaitement dans la démonstration chrétienne et le principe du "ça me ferait bien chier que ça ne soit pas ça" -

la fin de la matière noire .....

George Black a répondu à un sujet de bon ciel dans Astronomie générale

Non, l'analogie est bonne, mais vous avez raison, il faut la reformuler un peu. J'avais oublié votre cas, celui de Charles ! Afin de s'inscrire au concours, les participants devaient envoyer une courte vidéo dans laquelle ils décrivaient leur recette. Preuve que les organisateurs ne sont pas sectaires, ils ont accepté la participation d'Alice et Bob. Evidemment, je n'ai pas parlé des autres concurrents, qui n'ont pas gagné, mais n'ont pas démérité. Curieusement, Charles aussi avait une recette de chocolat au Bleu de Bresse et piment. Quand les organisateurs du concours ont réalisé en visionnant sa vidéo que Charles semblait ignorer les règles d'usage au niveau sanitaire, mais surtout, en réalisant à l'écouter qu'il n'avait qu'une connaissance limitée en cuisine, ils n'ont pas donné suite. Depuis, Charles inonde de mails les organisateurs du concours en les insultants et en les traitant d'escrocs qui ne comprennent rien à la cuisine. Sur son site Internet, Charles explique que Alice et même Bob lui ont tout volé et qu'ils ont plagié sa recette, surtout Alice. On lui a volé sa gloire ! Il explique que depuis que la cuisine française lui a fermé ses portes, celle-ci n'est plus que l'ombre d'elle-même, qu'il aurait pu révolutionner la cuisine française, mais qu'au lieu de cela, elle ne vaut rien. Il publie les mails des organisateurs qui lui refusent les concours, et il y voit une preuve de sa supériorité en cuisine : le monde de la cuisine française a peur d'être tournée en ridicule devant le grand chef Charles. Bref, Charles est juste un rustre prétentieux. Et rien que pour ça, personne ne veut rien avoir à faire avec lui. J'ai un Charles dans mes relations professionnelles. Et franchement, tout le monde est soulagé qu'il parte en retraite ! Et ce n'est pas parce que son génie nous fait de l'ombre ! C'est juste un grossier personnage, imbus de lui-même et toxique ! Il est de ces gens champions pour dire que la communauté scientifique se fourvoie en tout et est incapable de remise en question alors que EUX savent ! (pardon, "eux ils sachent"). C'est lunaire !