Super-résolution en "apprentissage profond" : Essais sur Mars

Hello

Les prémisses de ce fil sont ici.

il faut trier un peu, ça part dans tous les sens ! L'apprentissage profond (en anglais "Deeplearning") concerne les applications d'intelligence artificielle, dans le vent actuellement et certainement encore plus dans le futur !.

La documentation sur le sujet est abondante, je cite ce lien par exemple, qui résume la chose et peut aussi servir pour ceux qui voudraient mettre les mains dans le cambouis. J'ai voulu voir ce que que ça donnait en ce moment (ça évolue très vite !) en astrophotographie.

ll faut savoir que les moyens actuels permettent aux astrams qui le souhaitent de tirer le maximum de leurs prises (peine que ne prennent pas les smartphotographieurs en général), les limites physiques en résolution étant principalement imposées par le diamètre de l'instrument réputé de qualité optique correcte.

Pour l'instant, on ne voit pas très bien comment des moyens automatiques pourraient faire mieux, quand tous les réglages de prise de vue ont été faits correctement (échantillonnage spatial, linéarité, etc).

Par contre des progrès sont toujours à attendre pour combattre les conditions externes ennemies de l'astram : turbulence, défauts optiques, qualité du capteur, et même les erreurs de l'astram : mise au point, bougé, etc, les limitations dans l'amélioration seront principalement dues à l'incontournable bruit. Ce qu'il faut éviter absolument ce sont les non-linéarités, irrécupérables. Et aussi, certains apprécieraient un post-traitement de leurs prises "tout en aveugle" ! Le principe est d'utiliser une base de données d'images réputées excellentes à tous points de vue (= dataset)

Pour des raisons diverses (droits d'auteur, confidentialité, etc.) ces bases de données sont rarement publiques, mais on en trouve sur le net.

Des réseaux neuroniques entraînés selon l'un ou l'autre de ces dataset sont parfois publiés, sous forme de fichiers associés à des logiciels de traitement dédiés.

Ces dataset concernent les diverses formes de photo classique.

Certains sites permettent de se fabriquer ses propres réseaux pré-entraînés et de les utiliser comme les réseaux généralistes pour faire des traitements de netteté, de débruitage et d'agrandissement 2x et 4x en super-résolution. Ces traitements essaient de faire ressembler l'image de départ à une synthèse robotisée des images de référence, et en astro il faut trouver la limite de ce qui n'est plus véridique, on ne fait que débuter dans ce domaine !

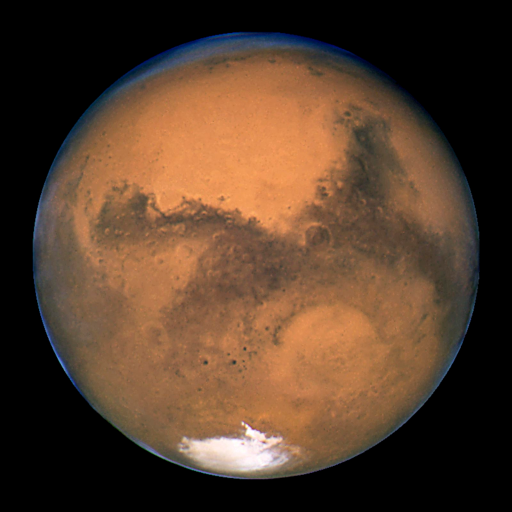

Et quand on est béotien en informatique comme moi, on essaie de s'instruire, grâce au net . Pour le rendu des détails on peut avoir une idée de l'asymptote des traitements par comparaison avec les images des gros scopes publiées sur le net (soigneusement redimensionnées) et en jouant avec ce bon vieux mais toujours d'actualité Aberrator. Pour ces premiers essais, j'ai trouvé dans un fil de Christophe P consacré à Billyjoe (Yann), que je remercie d'avance de me permettre d'utiliser ses images, une très belle vue de Mars : Alors pourquoi vouloir "l'améliorer" ? Et bien, juste pour voir, pour commencer avec une déjà excellente image pour moi (on continuera plus tard avec les bouses), ce qu'apporte tout ce bazar d'IA. Pour la comparaison des résultats, j'ai trouvé une vue de Mars au HST en 2016

qui correspond assez bien à la prise de Yann, à redimensionner en 17%

et une autre en 2001 un peu plus décalée en latitude mais bien exploitable aussi pour valider des détails. Pour appliquer les traitements IA à l'image de Yann (j'aimerais bien pouvoir partir ensuite aussi de l'empilement non traité, merci Yann, si tu passes par là ), je propose trois méthodes, noter que les sites cités ci-dessous ne sont pas exclusifs :

- 1. Les sites "one drop" :

On leur jette simplement une image, ils renvoient le résultat. a) Le plus simple : http://phancer.com/

Cliquer sur "UPLOAD YOUR OWN", faire glisser l'image dans la case "Select picture", sans s'occuper des histoires de smartphones.

Ce site permet aussi de jouer dans la catégorie 3 ci-dessous, mais pas avec un PC, je vous laisse l'explorer b) Plus technique : https://blog.deepsense.ai/using-deep-learning-for-single-image-super-resolution/

Pour des images de taille > 128x128, il faut bidouiller :

Découper l'original (ici 256x256) en tuiles128x128 se chevauchant, les jeter une par une, on les récupère traitées et agrandies 4x, les assembler (j'ai utilisé ICE) et redimensionner l'assemblage en 25% 2. Les sites "Réseau prétraité et logiciel d'application" a) http://webdav.tuebingen.mpg.de/pixel/enhancenet/

Il faut télécharger "Pre-trained model (zip)" et avoir un "Python" dans sa bécane. Pour un simple essai de béotien, je conseille "Winpython", c'est ensuite facile à faire, je peux dire comment si ça intéresse quelqu'un. b) https://github.com/alexjc/neural-enhance

Très technique et pas évident pour les non-informaticiens, projet apparemment en rade, j'en parle abondamment dans le fil des prémisses. Mais il ouvre la porte vers la catégorie 3 : 3. Sites "Réseau personnalisé et logiciel d'application" a) https://github.com/alexjc/neural-enhance J'ai constitué un micro-dataset avec trois images HST de Mars (différente de celle de Yann, pour débusquer un risque de clonage) Jupiter, Saturne :

Pour éduquer le modèle, je me suis limité à 10 itérations (une longue nuit d'hiver !) au lieu des 250 préconisées, mais c'est déjà parlant! b) http://phancer.com/

Seulement pour certains smartphones !

Alors voici les résultats (cliquer plusieurs fois dans l'image jusqu'à obtenir l'affichage 100%) : De gauche à droite :

Haut :

1 L'original de Yann

2 Traitement 1a

3 Traitement 1b

4 Traitement 2a

5 Traitement 2b, avec le réseau proposé par défaut

6 Traitement 3, avec réseau personnalisé astro rudimentaire A l'oeil, pour moi, la 4 mène la course ! Elle s'en sort bien mieux que les autres pour les Fs > 0.3 Au centre : 7 L'image HST en 17 %

8 Simple reprise en FFT 2D de la 4 alignée (à un petit coup de pouce près ) En bas, les FFT :

1 Gris

4 Jaune

7 Rouge

8 Magenta

Pour l'instant, sauf erreur, l'apprentissage profond ne mène pas directement au meilleur résultat final mais peut y contribuer de manière importante.

WebDav mérite d'être suivi de près. Il propose par ailleurs des dataset de très haute qualité.

Contacté au sujet de la possibilité de la création d'un réseau personnalisé, l'auteur m'a répondu :

"We are currently not planning to release training code"

Il reste à faire le plus important : tester sur des empilements bruts et les autres planètes.

PS: Pour en savoir plus sur la super-résolution, vous pouvez parcourir les messages de "ms" sur les divers forums d'Astrosurf et visiter régulièrement son site EVA

il faut trier un peu, ça part dans tous les sens ! L'apprentissage profond (en anglais "Deeplearning") concerne les applications d'intelligence artificielle, dans le vent actuellement et certainement encore plus dans le futur !.

La documentation sur le sujet est abondante, je cite ce lien par exemple, qui résume la chose et peut aussi servir pour ceux qui voudraient mettre les mains dans le cambouis. J'ai voulu voir ce que que ça donnait en ce moment (ça évolue très vite !) en astrophotographie.

ll faut savoir que les moyens actuels permettent aux astrams qui le souhaitent de tirer le maximum de leurs prises (peine que ne prennent pas les smartphotographieurs en général), les limites physiques en résolution étant principalement imposées par le diamètre de l'instrument réputé de qualité optique correcte.

Pour l'instant, on ne voit pas très bien comment des moyens automatiques pourraient faire mieux, quand tous les réglages de prise de vue ont été faits correctement (échantillonnage spatial, linéarité, etc).

Par contre des progrès sont toujours à attendre pour combattre les conditions externes ennemies de l'astram : turbulence, défauts optiques, qualité du capteur, et même les erreurs de l'astram : mise au point, bougé, etc, les limitations dans l'amélioration seront principalement dues à l'incontournable bruit. Ce qu'il faut éviter absolument ce sont les non-linéarités, irrécupérables. Et aussi, certains apprécieraient un post-traitement de leurs prises "tout en aveugle" ! Le principe est d'utiliser une base de données d'images réputées excellentes à tous points de vue (= dataset)

Pour des raisons diverses (droits d'auteur, confidentialité, etc.) ces bases de données sont rarement publiques, mais on en trouve sur le net.

Des réseaux neuroniques entraînés selon l'un ou l'autre de ces dataset sont parfois publiés, sous forme de fichiers associés à des logiciels de traitement dédiés.

Ces dataset concernent les diverses formes de photo classique.

Certains sites permettent de se fabriquer ses propres réseaux pré-entraînés et de les utiliser comme les réseaux généralistes pour faire des traitements de netteté, de débruitage et d'agrandissement 2x et 4x en super-résolution. Ces traitements essaient de faire ressembler l'image de départ à une synthèse robotisée des images de référence, et en astro il faut trouver la limite de ce qui n'est plus véridique, on ne fait que débuter dans ce domaine !

Et quand on est béotien en informatique comme moi, on essaie de s'instruire, grâce au net . Pour le rendu des détails on peut avoir une idée de l'asymptote des traitements par comparaison avec les images des gros scopes publiées sur le net (soigneusement redimensionnées) et en jouant avec ce bon vieux mais toujours d'actualité Aberrator. Pour ces premiers essais, j'ai trouvé dans un fil de Christophe P consacré à Billyjoe (Yann), que je remercie d'avance de me permettre d'utiliser ses images, une très belle vue de Mars : Alors pourquoi vouloir "l'améliorer" ? Et bien, juste pour voir, pour commencer avec une déjà excellente image pour moi (on continuera plus tard avec les bouses), ce qu'apporte tout ce bazar d'IA. Pour la comparaison des résultats, j'ai trouvé une vue de Mars au HST en 2016

qui correspond assez bien à la prise de Yann, à redimensionner en 17%

et une autre en 2001 un peu plus décalée en latitude mais bien exploitable aussi pour valider des détails. Pour appliquer les traitements IA à l'image de Yann (j'aimerais bien pouvoir partir ensuite aussi de l'empilement non traité, merci Yann, si tu passes par là ), je propose trois méthodes, noter que les sites cités ci-dessous ne sont pas exclusifs :

- 1. Les sites "one drop" :

On leur jette simplement une image, ils renvoient le résultat. a) Le plus simple : http://phancer.com/

Cliquer sur "UPLOAD YOUR OWN", faire glisser l'image dans la case "Select picture", sans s'occuper des histoires de smartphones.

Ce site permet aussi de jouer dans la catégorie 3 ci-dessous, mais pas avec un PC, je vous laisse l'explorer b) Plus technique : https://blog.deepsense.ai/using-deep-learning-for-single-image-super-resolution/

Pour des images de taille > 128x128, il faut bidouiller :

Découper l'original (ici 256x256) en tuiles128x128 se chevauchant, les jeter une par une, on les récupère traitées et agrandies 4x, les assembler (j'ai utilisé ICE) et redimensionner l'assemblage en 25% 2. Les sites "Réseau prétraité et logiciel d'application" a) http://webdav.tuebingen.mpg.de/pixel/enhancenet/

Il faut télécharger "Pre-trained model (zip)" et avoir un "Python" dans sa bécane. Pour un simple essai de béotien, je conseille "Winpython", c'est ensuite facile à faire, je peux dire comment si ça intéresse quelqu'un. b) https://github.com/alexjc/neural-enhance

Très technique et pas évident pour les non-informaticiens, projet apparemment en rade, j'en parle abondamment dans le fil des prémisses. Mais il ouvre la porte vers la catégorie 3 : 3. Sites "Réseau personnalisé et logiciel d'application" a) https://github.com/alexjc/neural-enhance J'ai constitué un micro-dataset avec trois images HST de Mars (différente de celle de Yann, pour débusquer un risque de clonage) Jupiter, Saturne :

Pour éduquer le modèle, je me suis limité à 10 itérations (une longue nuit d'hiver !) au lieu des 250 préconisées, mais c'est déjà parlant! b) http://phancer.com/

Seulement pour certains smartphones !

Alors voici les résultats (cliquer plusieurs fois dans l'image jusqu'à obtenir l'affichage 100%) : De gauche à droite :

Haut :

1 L'original de Yann

2 Traitement 1a

3 Traitement 1b

4 Traitement 2a

5 Traitement 2b, avec le réseau proposé par défaut

6 Traitement 3, avec réseau personnalisé astro rudimentaire A l'oeil, pour moi, la 4 mène la course ! Elle s'en sort bien mieux que les autres pour les Fs > 0.3 Au centre : 7 L'image HST en 17 %

8 Simple reprise en FFT 2D de la 4 alignée (à un petit coup de pouce près ) En bas, les FFT :

1 Gris

4 Jaune

7 Rouge

8 Magenta

Pour l'instant, sauf erreur, l'apprentissage profond ne mène pas directement au meilleur résultat final mais peut y contribuer de manière importante.

WebDav mérite d'être suivi de près. Il propose par ailleurs des dataset de très haute qualité.

Contacté au sujet de la possibilité de la création d'un réseau personnalisé, l'auteur m'a répondu :

"We are currently not planning to release training code"

Il reste à faire le plus important : tester sur des empilements bruts et les autres planètes.

PS: Pour en savoir plus sur la super-résolution, vous pouvez parcourir les messages de "ms" sur les divers forums d'Astrosurf et visiter régulièrement son site EVA