-

Compteur de contenus

5 267 -

Inscription

-

Dernière visite

-

Jours gagnés

1 -

Last Connexion

Soon available - 42403

Messages posté(e)s par patry

-

-

Nota; je me suis rapidement débarrassé du réducteur 0,33 pour ne conserver que le 0,63 qui lui fonctionne assez bien (C8, C11).

Marc

-

Le réducteur 3.3 est "un peu" ancien et ne couvrait (et encore) que le format 1/4 pouce d'une webcam. Avec le 1/2 pouce d'une PL1M (ca ne nous rajeunit pas) les coins sont dans le noir, c'est dire si c'est étroit. J'avais fait le test avec un C8, mais c'est adaptable sur un C6/C5 ou un C11/C14 !

Donc sur les caméras modernes qui font ressembler ces antiquités à des confettis, cela ne marchera pas bien ... pas bien du tout !

Mais bon, si tu a le tout n'hésite pas à te faire ton opinion.

Marc

-

On voit (photo #2) que le bord intérieur est "piqué", et que cela ressemble à des moisissures.

Donc à moins de vouloir se lancer dans un démontage / nettoyage et remontage complet du téléobjectif (avec tous les risques de centrage à faire pour tout les groupes de lentilles), il faudra vraiment qu'il ne soit pas cher pour que cela soit "rentable".

Moi perso je passerai mon tour.

Marc

-

Sur mon C8 orange (Un Celestron Pacific également) j'ai oublié un jour le connecteur d'alimentation. Du coup j'ai viré le connecteur de l'époque pour un IEC plus récent (et qui se trouve partout).

Des années plus tard je suis passé à l'Ulitma et là, plus besoin de fil à la patte.

Belle bête ce C14 en tout cas.

Marc

-

1

-

-

Etonnant un tel écart !

Le changement (de collimation) viendrait alors du correcteur ?

il y a 15 minutes, boss351 a dit :problème réglé alors

Pas vraiment si on doit utiliser le correcteur !

Le mieux serait de collimater avec si tu dois t'en servir. Tout comme il est préférable (en planétaire) de collimater avec le train d'imagerie complet il me semble utile de minimiser les défauts avec le correcteur. Mais je ne suis pas un spécialiste du CP, peut être que c'est différent.Marc

-

Tout comme Jérome, au C11 sur une EQ6, j'oriente la monture vers le pôle, l'alignement polaire se contente de placer l'étoile +/- dans le petit cercle et c'est très largement suffisant pour faire des poses de quelques dizaines de ms.

Pas de Nina, pas de lunette guide (poids inutile), j'ai juste un chercheur 50mm que j'installe de temps à autre, et avec des expositions aussi courtes la mise au point se fait en direct, sur ce que tu veux imager. La mise au point électrique c'est un confort certain mais pas une nécessité.

Marc

-

1

-

-

En fait tout dépend de ton usage.

En monochrome (ASI178 p.ex) quand je suis en R+IR (filtre 23A) ou R ou V ma limite d'usage monte. Sur une abaque de Jean Pierre Prost. un C8 est limité dans le bleu (intrabande) en dessous de 60° ou 70° de hauteur de mémoire. Mais en R+IR, la limite est de 25°. Mais si tu veux imager en L, alors là c'est un peu la cata et l'ADC est plus qu'indispensable ! Avec une caméra couleur tu pourra toujours recaler les couches R, G et B individuellement ce qui compense un peu la perte !

Je suis en tout cas surpris que tu n'atteigne pas la moitié de la plage de réglage de l'ADC ! Peut être que le mien (qui est un retrofit d'un mk1) dispose de prismes différents ?

Marc

nota : j'ai retrouvé l'abaque

http://www.astrosurf.com/prostjp/images/Atmospheric dispersion effect small.jpg

-

Un copain avait raté celle de 99 et a décidé d'aller à Montreal voir celle ci. Je lui avait dit que dans une totale, il y a la période "avant la totalité" et la période de la totalité. Mais celle qui suit, qui est à 99% ou 95% peut être encore ... qui s'en souvient ?

A ce moment là souvent on commence à plier (en 1999 il s'était remis à pleuvoir c'était normal), et mon pote m'a dit la même chose. Le soleil est revenu, merci au revoir ! A part le boitier qui continue pendant encore de longues minutes à photographier un chapelet, on a eu ce que l'on voulait !

En fait tout (la préparation, le stress, le montage, les discussion depuis parfois des années) ne sont là que pour converger vers quelques dizaines de secondes de temps suspendu.

Maintenant il y a des chanceux, des amis qui habitaient en Normandie en 1999 et ... à Montreal depuis 15 ans ! 2 totales en 25 ans sans bouger de chez soi, elle est pas belle la vie ?

Marc

-

3

-

-

Bravo, j'ai des amis qui sont de Montreal et un autre qui a fait le voyage qui ont aussi "bien véçu" comme toi cette totale.

C'est super, surtout que la météo semblait favorable.

Marc

-

1

-

-

Et la collimation ?

En fait pour une planète c'est (à priori) pas trop problématique sur une ASI178 (au pire utilisée verticalement) en jouant du ROI sur 1/2 largeur ou 1/2 hauteur.

Cela se complique sur l'ASI462 avec son capteur riquiqui évidemment.

Mais en lunaire cela ne marche plus et il FAUT corriger l'offset sinon tu perds vraiment trop de champ par la simple correction en jouant du ROI !

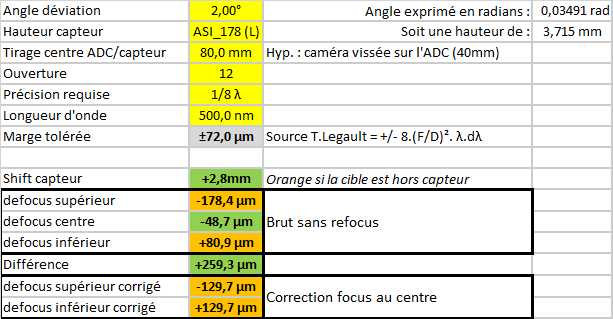

Par exemple, pour une déviation de 2° (un peu plus de la moitié de la plage d'un ADC PA Mk3), à F12 et pour L/8, tu a une marge de focus de 72µm. Ta cible est décalée de 2,8mm ce qui passe encore dans le capteur sans "shift".

Mais ton champ (supposé plan) est dévié et ton capteur (là une ASI178 verticalement) est décalé de 178µm en "haut" et de 81µm en "bas". Tu peux corriger le focus de ~50µm mais tu a toujours 130µm de defocus entre les bords du capteur. Tu va perdre plus de la moitié de la surface utile à cause du tilt du champ c'est pour moi rédhibitoire et montre la limite d'usage de l'ADC (en tout cas dans cette forme à 2 prismes).

C'est bien pire à F8 la tolérance passe à 32µm mais le defocus reste de +/- 130µm une fois corrigé ... mais 64µm sur 260µm il ne reste plus que 25% du capteur utilisable.

J'avais pensé faire un système de correction du tilt mais il faudrait jouer à la fois sur l'offset et le tilt ... cela se présente comme un cylindre, et l'impression 3D d'un accouplement cylindrique pose quelques difficultés (on est pas obligé non plus c'est vrai, on peut passer par un triangle qui pivote en un de ses sommets). Plus le fait qu'il faut déterminer à l'avance le rayon de courbure et le centrage sur l'ADC. Bref beaucoup de problématiques donc j'ai volontairement négligé le problème pour me simplifier la vie ! Et comme je suis souvent entre F10 et F25, je le vis assez bien je dois dire.

Marc

-

Il y a 11 heures, QGineys a dit :tu parles de la platine xy? J’en reçois une très bientôt.

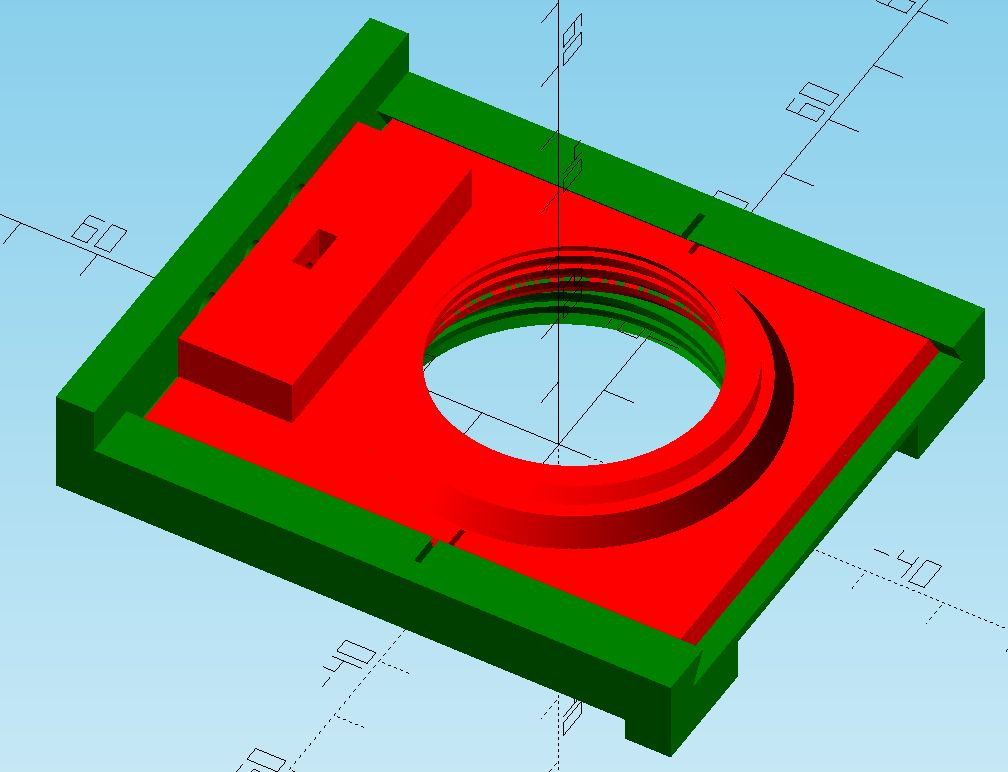

Presque ! Un copain m'a passé la platine XY orion, mais c'est inadapté car le mouvement sur l'axe horizontal est inutile en plus que gênant !

J'ai conçu un montage sur un seul axe bien plus "facile" à l'usage (ma platine "V2").

En situation (en version1) ... avec à l'époque un niveau sur l'axe de l'ADC. Il est désormais placé sur la platine fixe (verte) et l'ADC orienté une fois pour toute sur la platine.

Marc

-

1

-

-

Il y a 11 heures, QGineys a dit :l adc pa est en tous cas, pour ma part, bien plus simple d’utilisation

Complètement d'accord. J'ai mis à jour mon ADC PA vers la dernière version parce que la version à deux index est incomparablement moins simple d'usage.

Monté sur une platine de correction d'offset et d'un niveau à bulle, c'est redoutable d'efficacité.

Marc

-

1

-

-

Déjà primo ; il faut éviter autant que possible le traitement à partir de fichiers JPEG qui sont des données compressées (parfois beaucoup).

Ensuite, ton image initiale souffre d'un défaut de mise au point, là malheureusement, le traitement n'y fera pas grand chose et le gain assez anecdotique (quand il existe).

Enfin, une bonne nouvelle, ton image finale n'est pas perdue, seulement que le compositage (cad l'addition d'images individuelles) fait forcément monter la luminosité absolue mais en vérité ce n'est qu'une question d'histogramme. Ton Jpeg va peut être du niveau 0 (noir) à 200 (zone claire) sur 256 niveaux possibles. Tu additionne 2 images, tu va de 0 à 400, mais sur une plage de 512, etc etc ...

La visualisation doit être recalée pour présenter la même "plage visuelle", rien de grave donc.

Marc

-

J'ai mis à jour l'an dernier mon portable "Astro". Pour cela j'ai trouvé un ASUS d'occasion (300€) avec un i5 de 10e génération (pas le plus véloce mais il fait le boulot), écran FHD (important ça) et assez léger, que j'ai upgradé. Il est arrivé avec 8Go de RAM, et j'ai ajouté 8Go de plus pour faire bonne figure. J'ai ensuite complété son SSD Intel M2 de 512Go par un SSD de 1To Samsung qui héberge tranquillement les captures. Attention si en planétaire c'est assez large, en lunaire les Go disparaissent très très vite et il m'arrive de devoir transférer quelques fichiers durant la nuit sur un SSD que j'ai externalisé avec une interface USB3/SATA. Il devait y avoir W10pro et finalement c'est un W11pro que j'ai récupéré.

La nuit, il capture sans problème et engrange le flux de la caméra sans difficulté (ASI464, mais c'est facile, et surtout ASI178 mono qui est sensiblement plus exigeante avec 100Mo/s de plus).

Ensuite, le traitement est fait correctement sans plus. Bon cela reste remarquable que le i5 (de portable) qui ne consomme que 15W, fasse jeu égal avec un i7 (de bureau) de 4~5e génération qui nécessite 10x plus de watts !

Par contre, au boulot, j'ai récupéré un DELL avec un i5 de 13e génération (1345U)... pfff là c'est pas la même histoire, il va vraiment beaucoup plus vite (de 4C/8T on passe à 2P+8E/4T+8E avec sensiblement plus de puissance). En gros il y a peut être un facteur 2 tout en consommant 15W nominalement mais le double en charge (25W -> 55W). Pour un portable, attention à l'autonomie. Mais bon, tu ne fera pas le traitement loin d'une prise de courant de toute façon et ce qui compte c'est que durant la capture, la charge ne dépasse pas quelques % de CPU. Je l'ai même vu descendre la fréquence pour gagner encore en autonomie. Bon par contre aujourd'hui on le paye encore le prix fort entre 1000 et 1500€, il faut attendre encore un peu (j'avoue que dans 3 ans, si ma boite revend son parc, pour une fois je serais tenté de racheter le portable). Il y a un vrai écart entre les générations 10/11, puis 12 et maintenant 13 pour le coup ! En tout cas, si tu "peux", clairement tu ne sera pas déçu !

Marc

-

Sur mon C11, la queue d'aronde est fixé de la même manière. Pas de soucis à avoir, surtout au C8 pour tenir un tube de 5kg (6 avec un crayford) et surtout aussi court que le C8 !

Marc

-

-

Très belle résolution. Tu devrais essayer au filtre R (voire 23A) pour gagner encore un poil dans ce domaine ; même si cela semble incongru, virer le bleu, et éventuellement le vert les soirs moyens, permet d'obtenir un vrai gain en finesse. Et avec un filtre de type 23A (R+IR) tu ne perdra même pas en flux sur la 178, surtout avec ton diamètre bien plus sensible que le C11 aux moindres caprices du ciel !

Nota : c'est vrai que cela caille, et de mon coté, ce doit être l'âge, mais j'avais l'impression qu'il faisait -15 alors que le thermomètre affichait un petit -2° l'autre soir. Déjà que je suis peu motivé quand il fait froid, quand j'ai vu de la buée sur la face interne de la lame j'ai fini par craquer et je pense retourner hiberner jusqu'au printemps

Marc

-

1

1

-

-

Je viens de récupérer un nouveau portable pour le boulot, équipé d'un i5 de 13e génération, et bien je peux vous dire que cela dépote, même en version "U" (ce sont les versions très basse consommation).

Pas moins de 10 coeurs (2 "performance core" et 8 "efficiency core", pour 12 threads au total grace à l'hyperthreading sur les P-cores), le tout dans une enveloppe de 15W (maximum de 55W ce qui est énorme pour un portable).

Là la messe est dite et mon vieux i7 (4 coeurs, 8 threads), qui faisait encore jeu égal avec un i5 de 10e génération, est complètement largué.

J'ai fait 2 ou 3 tests avec Astrosurface et je dois dire que le i5 n'a pratiquement pas le temps de chauffer que le traitement est fini ! C'est remarquable. Pour une fois qu'on a des bonnes machines au boulot j'en profite. Cela me conforte dans l'idée de changer ma tour à la maison pour un i5 performant ou un i7, sur laquelle je pourrais me connecter pour faire les traitements.

Marc

-

L'exercice a été réalisé (par un allemand je crois) voilà quelques années mais je ne trouve plus la trace de cette page.

En substance, avec la lame positionnée comme tu veux le faire, le champ était devenu très propre. Par contre il avait laissé les vis de collimation et ouvert une trappe d'accès comme on le fait pour une chambre de Schmidt en fait !

Le tube devient évidemment 2x plus long mais ce n'est plus trop un problème aujourd'hui qu'on utilise plus trop de monture à fourche.

Beau projet en tout cas, je vais suivre cela avec curiosité.

Marc

-

1

-

-

Oui j'ai oublié de mentionner ce point ! Les versions dites "portables" sont en réalité des processeurs +/- castrés par leur consommation.

Un i5 de bureau va consommer entre 65 et 120W ! Et la version mobile 5 à 10 fois moins. Alors ne pas se laisser avoir et la performance reste correcte mais sur un temps (très) limité car la capacité de refroidissement d'un portable est très loin de celle d'une tour et donc le processeur va très rapidement réduire sa performance.

Grosso modo, un i7 "portable" se situe en réalité en dessous d'un banal i5 de tour voire d'un i3 un peu énervé. Je crois qu'il a existé un cas d'un montage d'un processeur de tour dans un portable mais l'autonomie se comptait en quelques dizaines de minutes évidemment et la performance bridée par la pauvreté du refroidissement !

Par contre l'écart générationnel va compenser la perte et j'ai acquis un portable d'occasion disposant d'un i5 de 10e génération (4 coeurs) qui se situe +/- au même niveau de performance de mon i7 de tour ... de 4e génération (4 coeurs aussi, mais qui tournent un peu plus vite et qui réclame près de 80 à 120W je crois, contre 10W pour le petit). Disons que cela me permet de faire quelques tests vite fait sur le terrain. Mon objectif à moyen terme serait un i5 de 13e génération avec une carte graphique (car je ne fait pas que de l'astro aussi), 32 Go de RAM et un SSD de 1To (pas de changement).

Marc

-

Pas mieux, pour du "processing" il faut un gros CPU, i5 (minimum), i7 (idéal) ou i9 (luxueux) car rares (aucun ?) de nos logiciels astro n'utilisent les capacités de calcul des cartes graphiques ! Hormis pour de l'affichage mais franchement dans ce cadre là, même un GPU intégré fait le travail sans impact sur la performance ressentie de l'utilisateur.

Coté mémoire, la règle c'est que ce soit équilibré par rapport entre le nombre de coeurs et la mémoire. Car plus on a de coeurs, plus on va pouvoir lancer de processus simultanément (ou distribuer un traitement sur plusieurs unités de traitement), plus il faudra de mémoire pour faire travailler ces processus. Il n'y a pas de formule préétablie (on a des trucs pour dimensionner les "fermes" mais c'est lié à d'autres métiers).

Enfin évidemment il faut "alimenter" cette mémoire et là il faut envisager la mémoire de stockage à court/moyen terme et le SSD en nvme s'impose avec une capacité autour de 1To qui reste suffisante et encore économique. Pour du stockage à long (et très long) terme, un nas avec des disques mécanique reste une bonne solution avec un prix au Go infiniment inférieur au SSD, surtout qu'en général on utilise un accès distant => donc via un réseau et qu'alors rien ne sert de pouvoir lire un fichier à 235242 Go/s si c'est pour l'envoyer sur un réseau 1Gbps ou 10Gbps !!!

Un i7, 32Go et 1To de SSDnvme donne un ensemble cohérent qui se retrouve souvent dans des configurations dites "gaming" avec en plus une carte graphique performante mais qui ne servira pas pour notre usage. Mais tu peux passer sur un i5 (à peine moins performant en réalité), et lui adjoindre une carte graphique "correcte" si le PC est aussi utilisé pour jouer. La baisse de performance (en astro) sera modérée mais le gain (pour jouer) sera immense (tant la carte graphique est primordiale dans ce cas) et ce pour un tarif quasi semblable.

Marc

-

C'est étudié pour (normalement) et il y a quelques mm de marge (C8, C11 et j'avais regardé sur un C14 en prêt). Car si le secondaire dépassait, on ne pourrait pas mettre le cache !

Et puis même à plat, le cache porte sur le "pourtour". Par contre le risque serait de poser le tube sur un objet qui "dépasserait" (un caillou ?). Mais bon faut un minimum faire attention.

Marc

-

1

-

1

1

-

-

Pareil, je démonte mon tube de sa monture et je le stocke (une fois bien sec) tête en bas dans son sac.

Jamais de problème et la collimation est bien retrouvée à chaque fois.

Marc

-

1

-

1

1

-

-

C'est vrai qu'un réducteur 3.3 avec une de ces nouvelles caméras avec des photosites de ~1µm permet, au prix d'un très fort crop, de faire des images tout en conservant quelques pixels. Parce que la webcam (ou la DMK21) c'est 640x480, un peu pauvre aujourd'hui quand on ne jure que par des dizaines de MPixels !

Et surtout on se retrouve avec une ouverture de 3.3. Je ne me rappelle pas de la qualité du champ (et puis les photosites étaient "gros" à l'époque).

Marc

Remplacement Skysensor 2 et Chambre de Schmidt

dans Astronomie pratique

Posté(e)

La longueur est "simplement" le double de celle d'un C8 car la lame y est "à sa place" dans la chambre de schmidt. Par contre comme dit, le champ est également sphérique. Ce n'est pas un problème en argentique car le film était pressé sur un support sphérique et permettait d'avoir des étoiles de quelques µm sur plusieurs degrés², chose qu'on ne sait plus trop faire aujourd'hui !

En numérique il faudrait faire un correcteur "sur mesure", pas infaisable mais pas forcément évident non plus.

Marc